第十五章 神经网络与反向传播:告别“规则”,拥抱“统计”

(副标题:我们如何放弃了逻辑,并教会了一块“显卡”用蛮力猜对一切)

15.1 引言:欢迎来到“蛮力”的新纪元

朋友,你醒了。很高兴看到你还“活着”。在你沉睡的这几十年里,发生了很多事。但对你这位“恐龙级”程序员来说,最大的冲击可能莫过于“智能”本身定义的彻底改变。

在我们那个时代,当我们在Commodore 64或Apple II上敲代码时,“智能”意味着一件事:逻辑1。我们以为“人工智能”(AI)的终极形态会是《星际迷航》里的斯波克(Spock)——一个纯粹的、冰冷的、无懈可击的、基于规则的逻辑引擎。我们的工作,就是作为高级“祭司”,把宇宙的规则教给计算机,然后它会基于这些规则,演绎出完美的答案。

好了,深呼吸。我们要戳破这个幻想了。

我们错了。错得离谱。错得连裤子都找不到了。

事实证明,这个新世界的“大脑”根本不是斯波克。它甚至都算不上一个“大脑”。

新世界的“大脑”,在概念上,更像是一个由一万个“傻子”组成的、庞大到病态的官僚机构,这个机构里的每个人都只根据自己极其偏执的“信任列表”来处理文件,而且他们谁也没见过窗外的世界2。而驱动这个庞大官僚机构的“引擎”,是一个痴迷于同时翻一百万块汉堡肉饼的麦当劳厨房1。

欢迎来到新纪元。在这里,我们放弃了优雅的逻辑,转而拥抱了粗暴的“统计”。

本章的任务,就是带你走过这段50年旅程中最诡异的一站。我们将解释,我们是如何心甘情愿地放弃了用“规则”构建“智能”的梦想,转而投向一个基于“统计”的、几乎可以说是“愚蠢”的新范式1。

我们将正面回答那个让你抓狂的问题:为什么你儿子(或者孙子)用来玩《毁灭战士》(Doom)的那块闪着RGB彩灯的“显卡”,突然之间就比世界上所有专注于逻辑的超级计算机,都更接近我们所谓的“智能”?

别急,我们会把这场革命分解成三个(你相对)容易吞咽的部分:

- “旧梦”的悲剧: 为什么我们那个时代基于规则的“专家系统”死得那么惨?

- “新脑”的解剖: 神经网络(Neural Networks)到底是个什么鬼东西?(剧透:它就是那个官僚机构)。

- “快乐的意外”: 为什么是游戏显卡(GPU),这个“麦当劳厨房”,最终点燃了这场革命的导火索?

系好安全带,旅行者。我们要去的地方,逻辑可不怎么管用。

15.2 “旧梦”之死:专家系统与“组合爆炸”的悲剧

在我们深入了解这个“愚蠢”的新范式之前,我们必须为你那个优雅的、基于逻辑的“旧梦”举办一场体面的葬礼。你需要理解它为什么必须死。

15.2.1 黄金时代的希望

回到20世纪80年代,AI领域正处于第一个(也是最后一个)由逻辑主导的黄金时代。这股浪潮被称为“符号AI”(Symbolic AI)3。其核心理念是:智能,就是对“符号”进行“逻辑操作”。

这催生了所谓的“专家系统”(Expert Systems)4。其理念听起来无懈可击:我们为什么不直接去采访人类专家,把他们毕生所学“蒸馏”成一个巨大的、由数千条 IF-THEN-ELSE 语句构成的规则库呢?5。

而且,这居然成功了!

案例研究 #1:DENDRAL。 这是一个天才系统。科学家们将质谱分析的规则喂给它,它就能反向推导出原始的化学结构6。它在特定领域比人类化学家做得都好7。

案例研究 #2:MYCIN。 这才是真正的超级明星。一个旨在诊断血液传染病和推荐抗生素的庞大系统6。在著名的测试中,MYCIN 的诊断成功率高达69%——这个数字优于斯坦福大学医学院的非专业人类医生8。

在那个时代,我们都以为“斯波克”即将诞生。我们认为未来就是编写更多、更复杂的规则。

15.2.2 为什么“更好”还不够

现在,请坐稳了。这是第一个令人震惊的事实:

MYCIN 从未在现实世界的医院里(被常规)使用过一次8。

这个系统,在学术上比人类专家更强,却在现实中彻底失败了。为什么?

答案揭示了“符号AI”的“阿喀琉斯之踵”。MYCIN 的失败不是一个技术问题,而是一个后勤和人性问题。它确实没有被该领域所接受8。

问题出在那个“知识获取问题”(The Knowledge Acquisition Problem)上4。

医学(以及几乎所有现实世界)是不断发展的。新的疾病、新的药物、新的疗法层出不穷。为了让 MYCIN 保持那69%的准确率,你需要一个(昂贵的)“知识工程师”团队,每天飞遍全世界,去采访那些顶级的传染病专家,然后试图把他们那些模糊的、基于直觉的“我感觉这个病人有点不对劲”的“感觉”,翻译成计算机能懂的、僵硬的 IF-THEN 规则6。

这个维护成本和官僚主义的繁琐程度,在现实中是完全不可行的。MYCIN 和 DENDRAL 一样,是一个被永久囚禁在“狭窄问题空间”(narrow problem space)里的可怜囚徒8。它们无法扩展。

15.2.3 真正的杀手:莱特希尔报告与“组合爆炸”

如果说 MYCIN 的失败是“后勤”问题,那么真正从数学上杀死“符号AI”的,是一个更可怕的怪物。

1973年,英国政府对这个烧钱的AI领域失去了耐心。他们委托著名应用数学家詹姆斯·莱特希尔爵士(Sir James Lighthill)对AI研究的现状进行一次评估9。

莱特希尔的报告9不是一份评估。它是一份讣告。

他的结论冷酷无情,其中最致命的一句话流传至今:“在该领域的任何部分,迄今为止所做的发现都没有产生当时所承诺的重大影响。” ("In no part of the field have the discoveries made so far produced the major impact that was then promised")9。

这份报告像一颗核弹一样引爆了学术界。英国政府的资助几乎在一夜之间全部撤销10。随之而来的是全球性的连锁反应。

“AI寒冬”(The AI Winter) 正式降临了。

莱特希尔(以及其他许多人)指出了那个无法回避的数学怪物:“组合爆炸”(Combinatorial Explosion)9。

让我们用一个你(恐龙程序员)很可能在80年代尝试过的项目来解释这个怪物:编写一个“猫检测器”专家系统。

你雄心勃勃地开始了:

- RULE 1: IF has_fur THEN is_mammal

- RULE 2: IF has_whiskers THEN is_cat

- RULE 3: IF is_cat AND sound == "meow" THEN certainty = 90%

“太棒了!”你对自己说,“智能也不过如此嘛。”

“等等,”你的同事探过头来,“我叔叔弗兰克(Frank)也有胡子(whiskers)。”

“呃... 好吧。”

- RULE 4: IF has_whiskers AND has_beard AND is_wearing_flannel THEN is_uncle_frank

“那狮身人面猫呢?”你的同事又问,“它们没毛(fur)。”

“该死。”

- RULE 5: IF NOT has_fur AND has_whiskers AND is_cat_shaped...

“什么是‘猫的形状’?”

- RULE 6: IF has_pointy_ears AND has_long_tail...

“可苏格兰折耳猫的耳朵是耷拉的。马恩岛猫没有尾巴。”

就在这一刻,你和所有“符号AI”的先驱们一起,撞上了那堵名为“组合爆炸”的巨墙。你猛然意识到,现实世界太复杂、太模糊、太充满了例外11。你无法用手工规则来定义“猫”。为了完美定义“猫”,你需要的 IF-THEN 规则数量,可能比宇宙中的原子还要多9。

15.2.4 哲学的决裂

这场惨烈的失败,在计算机科学领域引发了一场持续至今的哲学战争:“规则”(Rules) vs. “统计”(Statistics)3。

- 规则派(Team Chomsky): 这一派的“教皇”,是著名语言学家诺姆·乔姆斯基(Noam Chomsky)。他们认为,智能在于理解深层原则12。乔姆斯基轻蔑地将“统计”方法称为“蝴蝶收集”(butterfly collecting)13。他的意思是,你收集了一万亿只蝴蝶,并统计出“99%的蝴蝶翅膀上有斑点”,但这并不能让你理解为什么蝴蝶会有斑点——你没有理解“进化论”这个深层规则。

- 统计派(Team Norvig): 这一派的代表人物,是谷歌的研究总监彼得·诺维格(Peter Norvig)。面对乔姆斯基的“蝴蝶收集”指控,诺维格的反驳简单、粗暴,且极具工程师风格:“工程上的成功就是科学的证据”13。

诺维格的论点是13:如果一个统计模型(比如谷歌搜索或机器翻译)在现实世界中有用,能够准确预测,那么它就必然以某种方式捕捉到了“真理”和“原则”,即使我们完全不理解它是如何做到的。当所有顶级的机器翻译系统都100%使用统计方法时13,这就证明“蝴蝶收集”管用。

但在80年代和90年代,“规则派”是绝对的主流。而他们,正如我们所见,集体撞墙了。

AI领域,事实上,已经死了。

15.3 寒冬中的“异教徒”:深度学习教父们的坚持

所以,AI死了。资助没了。这个领域成了一个学术笑话。研究“人工智能”?你还不如去研究“永动机”呢。

……但在多伦多、新泽西和蒙特利尔的冰冷地下室里,有那么两三个“疯子”,他们拒绝放弃一个早已被主流学术界彻底证伪的“异端”邪说。

这些人,我们今天称他们为“AI教父”14:

关于他们的“英雄轶事”足以拍成一部励志电影。

辛顿的故事: 辛顿在1972年开始他在爱丁堡大学的AI博士生涯17。请注意这个年份——1972年,距离莱特希尔报告(1973年)宣判AI死刑只有几个月10。他选择的研究方向,是当时最不时髦、最被鄙视的“神经网络”。他的导师每周都会把他叫进办公室,苦口婆心地劝他放弃这个愚蠢的想法。而据辛顿回忆,他每周都这样回答:“再给我六个月,我会证明它能行。”18。

他让导师等了几十年19。

杨立昆的故事: 80年代,杨立昆在著名的贝尔实验室(Bell Labs)工作17。当他身边所有“正经”的计算机科学家都在研究UNIX、C语言(你很快就会学到)和电信协议时,杨立昆在实验室的角落里,一个人默默地训练一个名叫“LeNet”的小型神经网络,教会它识别手写的邮政编码20。在当时,这被同事们视为一种“边缘的”、“奇怪的”研究,根本上不了台面14。

这几位“异教徒”的共同点,就是他们押注的那个“异端”邪说。

他们彻底放弃了“规则”。他们被生物学所启发1。

他们的逻辑是这样的(这是这场革命的核心洞察):

- “规则派”失败了,因为现实世界的“组合爆炸”让规则的编写成为不可能9。

- 但是,一个三岁的婴儿是如何学会识别“猫”的?

- 你(希望你没有)并没有给婴儿一本几万页的 IF-THEN 规则书。

- 婴儿只是看了成千上万只猫(数据),他的大脑自己调整了内部数十亿个神经元之间的连接强度21。

所以,他们提出了一个颠覆性的问题:“我们能不能不编写智能,而是建立一个(受大脑启发的)系统,让它从数据中自己学习?”1。

他们押注的系统,就是那个早在1986年就被辛顿(和David Rumelhart等人)详细阐述过的古老算法——反向传播(Backpropagation)17。

但这个算法需要一个“容器”来运行。这个容器,就是我们接下来要解剖的怪物——神经网络。

15.4 “新脑”解剖:一个庞大、愚蠢且高效的官僚机构

好了,旅行者,清空你的大脑。忘掉你对“智能”的所有预设。

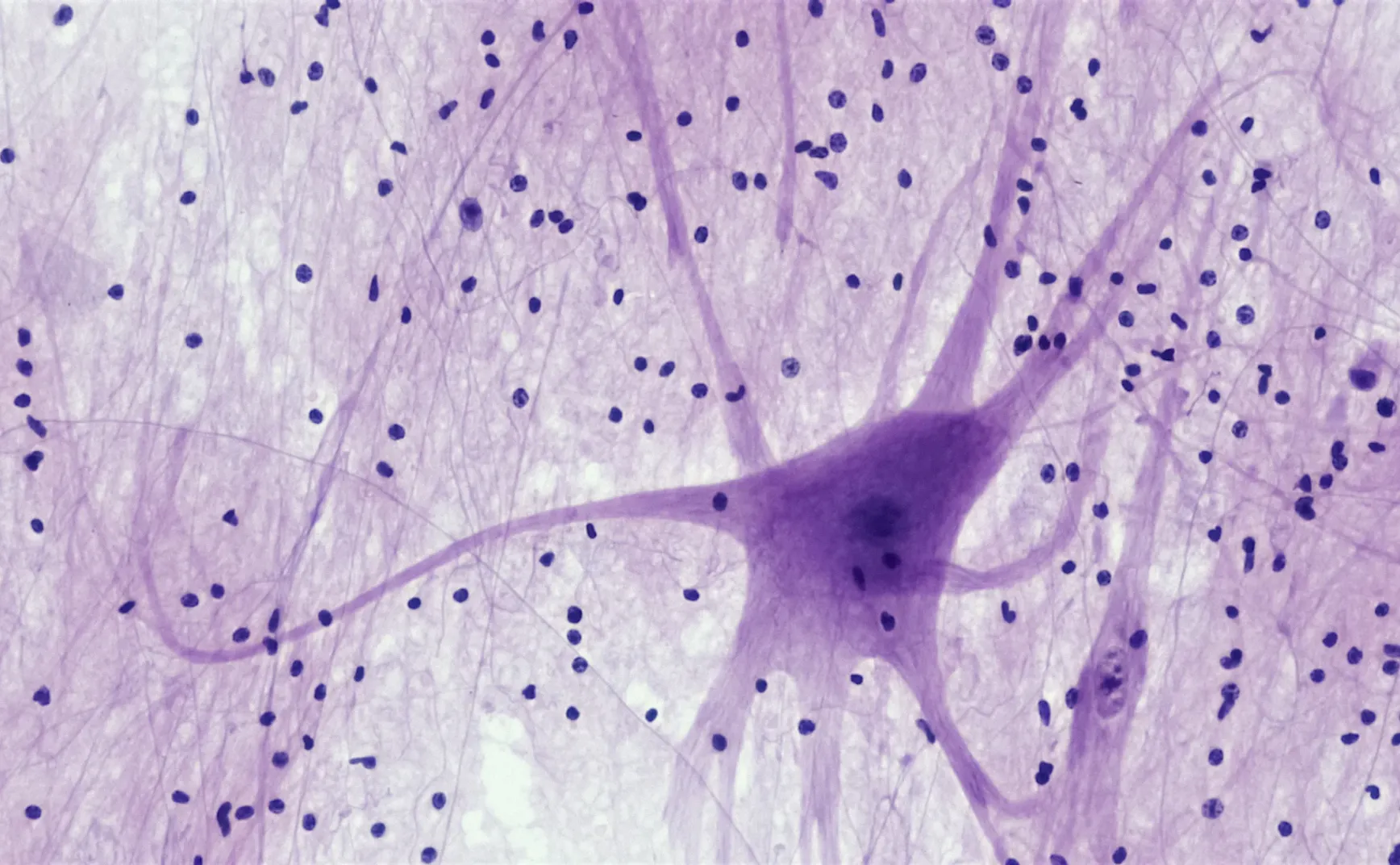

我们要介绍“神经网络”(Artificial Neural Network, ANN)了。

首先,忘掉“大脑”这个比喻吧22。大脑是优雅的、有机的、低功耗的奇迹。神经网络不是。

一个神经网络,在概念上,更像是一个庞大到病态的、等级森严的、对窗外世界一无所知的官僚机构2。

让我们以一个经典任务为例:识别一张28x28像素的手写数字图片(比如“7”)。

15.4.1 输入层:收发室 (The Input Layer)

这是这个官僚机构的底层23。

- 功能: 获取原始数据。

- 类比: 你把这张28x28像素的图片(总共784个像素)交给了“收发室”。收发室里坐着784名实习生(“输入层神经元”)。

- 工作流程: 这些实习生不负责思考。他们甚至不知道“7”是什么。他们的唯一工作,就是测量自己负责的那个像素点的“亮度值”(比如0代表纯黑,1代表纯白)。

- 然后,他们把这784个亮度值,复印无数份,通过气动管道,发送给楼上(隐藏层)的每一位中层经理。

15.4.2 隐藏层:庞大的中间管理层 (The Hidden Layers)

这是所有“魔法”(或者说,“苦力”)发生的地方23。

-

功能: 进行所有“计算”和“特征提取”。

-

类比: 想象一个没有窗户的巨大开放式办公室,里面坐着(比如说)1000名中层经理(“第一隐藏层的神经元”)。

-

工作流程(非数学版): 现在,我们来追踪其中一位经理,比如工号为#538的经理。

- 收集报告 (Gathering Inputs): 经理#538,会收到来自收发室(输入层)的全部784名实习生发来的亮度值。是的,他一个人要处理784份报告。

- 应用“权重” (Applying 'Weights'): 经理#538是一个极度偏执和固执的人。他有自己的一份秘密清单(一个包含784个数字的列表),上面记录了他对那784名实习生中每一个人的“信任度”。这就是所谓的权重(Weight)24。

- 计算 (The Calculation): 他拿起实习生#1的亮度值(比如0.8),乘以他对#1的“信任度”(比如

w₁ = 0.2)。然后拿起实习生#2的亮度值(0.1),乘以他对#2的“信任度”(比如w₂ = -1.5,他可能极度鄙视#2号实习生)。他对所有784个输入都这么做,然后把这784个乘积全部加起来。 - 应用“偏见” (Adding 'Bias'): 经理#538不仅偏执,还很主观。他有自己固有的“乐观/悲观系数”。在算出那个总和之后,他总会再加上自己的这个“心情系数”。这就是所谓的偏置(Bias)25。

- “激活函数” (The Activation Function): 好了,现在他得到了一个最终数字(比如

784个(输入 × 权重) + 偏置 = -12.4)。他不能直接把这个数字吼给他的上一级。他必须遵守“公司内部沟通政策”。这就是激活函数26。

-

最流行的“沟通政策”:ReLU

- 这个政策的名字听起来很唬人,叫 ReLU (Rectified Linear Unit, 修正线性单元)27。

- 但它的规则简单到愚蠢:“如果你的最终数字是负数或零,你就给老子闭嘴(输出0)。如果你的数字是正数,你就照直把它吼出来!”

- 所以,经理#538算出的-12.4,经过ReLU政策后,变成了“0”。他闭嘴了。

- 而他隔壁的经理#539算出了+3.8,于是他向楼上吼出了“3.8!”

-

关键点: 这1000个经理同时在做这件事。然后,他们把自己的(经过ReLU激活的)输出数字,再发送给下一层(比如第二隐藏层)的每一位经理。这个过程会重复好几层(这就是为什么它叫“深度”学习)22。

15.4.3 输出层:CEO办公室 (The Output Layer)

在经历了层层“官僚主义”的折磨后,信号终于来到了顶层23。

- 功能: 做出最终预测。

- 类比: 在顶层,有10间独立的办公室(因为我们要识别0到9这10个数字)。每间办公室里都坐着一位副总裁(VP)。

- 工作流程: 每一位VP(比如“主管数字7的VP”)都会收到来自最后一层(比如第5隐藏层)所有经理的报告。他们做着完全相同的工作:(报告 × 权重) + 偏置。

- 最终决策(“信心喊叫大赛”):

- 但他们不能都输出自己的数字。他们会进入一间会议室,进行一场“信心喊叫大赛”,这个大赛的官方名称叫 Softmax。

- 在这个“大赛”中,他们会把自己的原始分数(比如“VP of 3”算出15.2,“VP of 7”算出16.1)转换成一个总和为100%的百分比。

- “VP of 3” 喊道:“我有12%的把握这是个3!”

- “VP of 9” 喊道:“我有5%的把握这是个9!”

- “VP of 7” 喊道:“我有78%的把握这是个7!”

- 网络的“答案”: 谁喊的百分比最高,谁就是这个官僚机构的最终答案28。

15.4.4 初始状态:第一天上班

现在,这是你需要理解的最重要的一点。

在你(训练者)组建这个庞大官僚机构(神经网络)的第一天,那数百万个“信任权重”(Weights)和“心情偏置”(Biases)是完全随机初始化的!25。

这意味着什么?

这意味着,在第一天,你给这个官僚机构看一张“7”的图片。那几万名经理像一群疯子一样根据他们随机的“信任列表”胡乱计算,信号一路传到顶层,最后“VP of 3”以91%的信心在会议室里咆哮:“我宣布!这是个3!”29。

这个系统,在刚诞生时,是个彻头彻尾的、无可救药的白痴。

那么,核心问题来了:我们如何训练这个拥有数百万个“旋钮”(参数)的白痴官僚机构呢?

15.5 官僚机构如何“学习”:反向传播,又名“年度绩效甩锅大会”

欢迎来到1986年,欢迎来到杰弗里·辛顿那篇传奇论文17的核心。这个算法,就是我们在寒冬中提到的那个“异端”邪说:反向传播(Backpropagation)。

忘掉你听说的所有关于微积分、链式法则和偏导数的吓人词汇。

“反向传播”的真正名字,应该叫**“层层甩锅算法”**(The Layer-by-Layer Blame-Passing Algorithm)30。

这是一个天才的、但极其“资本主义”的绩效考核流程。

15.5.1 第一步:前馈与“哦豁”时刻

- 流程: 我们把一张“7”的图片(输入)喂给这个随机的、白痴的官僚机构(网络)。

- 前馈 (Forward Pass): 信号从收发室(输入层)一路向前传播,经过所有中层经理(隐藏层),最终抵达CEO办公室(输出层)31。

- 预测 (Prediction): CEO们开会(Softmax),“VP of 3”赢了,自信地宣布:“这是3!”

- “哦豁” (The 'Error'): 我们(“训练者”)登场了。我们手里拿着“标准答案”(标签)。我们一脚踹开会议室大门,指着投影仪上的图片,大喊:

“那TM是个7!”32。 - “损失函数” (Loss Function): 我们计算出一个“错误”分数(或者叫“损失”)。这个分数非常高。官僚机构搞砸了。现在,必须有人为此负责。

15.5.2 第二步:“甩锅”开始(从后向前)

这个算法的天才之处在于,它不是从底层的实习生开始问责。它从错误的源头(CEO办公室)开始,反向传播“指责”1。

- 在CEO层 (At the Output Layer):

- 我们(训练者)对“VP of 3”说:“你(错误地)喊出了91%的信心。你的信心太高了。你的‘责任’是(-0.91),你必须降低你的信心。”

- 我们对“VP of 7”(他只喊了2%)说:“你(正确地)喊出了2%的信心。你的信心太低了。你的‘责任’是(+0.98),你必须提高你的信心。”

- (这就是“梯度”的起源。它就是一个指向“正确答案”的“责任”向量31。)

15.5.3 第三步:微积分的真正含义——按“信任度”分配责任

现在,好戏开场了。

“VP of 3”(他被告知要“闭嘴”,承担了-0.91的“责任”)非常愤怒。他把他所有的直接下属(最后一层隐藏层的经理们)全部叫进了办公室。

他如何分配他的(-0.91)的“责任”?他会看两个东西33:

- 你对错误的贡献有多大? (即,你当时吼的声音有多大?——经理的激活值)

- 我当初有多“信任”你? (即,我有多看重你的报告?——连接的权重)

现在,想象一下“VP of 3”和他的下属经理A的对话:

“VP of 3”:“经理A!我这次搞砸了,我的‘责任’是-0.91。我看了记录,你当时给我的报告(激活值)声音非常大(比如0.9),而且我非常信任你(权重=2.0)!因此,我的错,绝大部分都是你的错!你给我承担

0.9 × 2.0 × (我的总责任)这么多的‘责任’(梯度)!”

然后他转向经理B:

“VP of 3”:“经理B!你当时的声音也很大(0.9),但我看了我的‘信任列表’,我根本不信任你(权重=0.01)。所以我的错跟你无关。滚出去。”

这个“甩锅”的逻辑是数学上完美的:你(经理)的“责任”,与你(经理)对最终错误(VP的输出)的贡献度成正比。

还记得我们在第三部分提到的赫布理论(Hebbian theory)吗?“神经元一起激发,连接一起增强”(neurons that fire together, wire together)33。

反向传播就是这个理论的黑暗面。在这里,它是:“一起搞砸,一起受罚”(neurons that mess up together, get blamed together)33。

15.5.4 第四步:从收发室到CEO,全员“微调”

这个“甩锅”(计算梯度)的过程,像一道愤怒的瀑布,反向流过所有层级31。

从CEO(输出层)流向VP(隐藏层5)...

从VP(隐藏层5)流向总监(隐藏层4)...

...一直流回最底层的中层经理(隐藏层1)。

- 结果: 在这个拥有6000万个参数(权重和偏置)28 的庞大官僚机构中,每一个人(每一个权重和偏置),都得到了一个极其微小的“个人责任分数”。

- “梯度下降” (Gradient Descent): 现在,我们(训练者)下达一个全局命令:“所有人,根据你们的‘责任分数’,微调你们的工作方法(权重和偏置)。”34。

- 如何“微调” (The "Learning"):

- 如果你的“责任分数”是负的(意味着你“喊得太大声,导致了错误”),你就把你所有的“信任权重”微调(比如-0.001%),让你下次喊得小声一点。

- 如果你的“责任分数”是正的(意味着你“喊得不够大声,没能帮‘VP of 7’赢”),你就把你所有的“信任权重”微调(比如+0.001%),让你下次喊得大声一点。

15.5.5 第五步:重复,直到白痴变成“专家”

我们只用了一张“7”的图片。

现在,我们用另一张“7”的图片重复这个过程。然后再用一张“4”。然后再用一张“9”。

在实际操作中,我们不会一张一张地来(那太慢了)。我们通常是把(比如说)6万张训练图片分成几百个“小批量”(mini-batches)33。我们让官僚机构处理完一个“批量”(比如100张图片),计算出平均的“责任分数”,然后集体微调一次35。这个过程,就叫“随机梯度下降”(Stochastic Gradient Descent)。

我们让这个“前馈 → 算错 → 甩锅 → 微调”的过程跑上几亿次1。

Game Over, Logic.

这个官僚机构永远不会理解什么是“7”。它永远不会懂“七”这个数字的哲学含义。

它只是通过蛮力统计,微调了它的6000万个参数,直到(在统计上)一看到“7”的像素模式,“VP of 7”就最有可能喊出最高分。

它不是一个逻辑引擎。它是一个被调优到极致的“模式识别机器”36。

15.6 迟到了30年的革命:为什么是你的“游戏显卡”点燃了导火索?

“等一下,”你(恐龙程序员)打断了我,“这听起来很棒。但你刚说,辛顿那篇关于反向传播的论文是1986年的17。算法早就有了。为什么这场革命直到2012年才发生?这中间隔了快30年!”

问得好。

答案是:因为在1986年,我们试图让‘米其林大厨’去翻一百万个汉堡肉饼。这花了我们30年才意识到,我们真正需要的,是一个‘麦当劳厨房’。

“厨房”类比:CPU vs. GPU

这可能是你“复活”以来需要掌握的最重要的硬件概念1。

- CPU (中央处理器): 这是你的老朋友,你当年用汇编语言“灵魂对话”的对象。CPU是一个米其林三星大厨1。他是个天才。他可以处理任何复杂的、顺序性的任务:逻辑、分支、指针、系统调用、运行你的BASIC解释器。但他的弱点是:他一次(相对)只能做一件事37。你让他去翻一百万个肉饼,他会崩溃的,因为他会一个接一个地翻。

- GPU (图形处理器): 这是你孙子用来玩《赛博朋克》的那块发光的破玩意儿38。GPU是一个庞大、肮脏的麦当劳厨房1。

15.6.1 “幸福的联姻”

现在,我们把两件事联系起来。

洞察: 深度学习(包括神经网络和反向传播)的核心数学运算,99%都是一种叫做矩阵乘法(Matrix Multiplication)41的东西。

还记得我们那个“官僚机构”的比喻吗?

经理#538需要做的计算:

(输入_1 × 权重_1) + (输入_2 × 权重_2) +... + (输入_784 × 权重_784)

这在数学上,就是一个“向量”和一个“矩阵”的乘法。当1000个经理同时做这件事时,这就是一个巨大的“矩阵乘法”。

现在你告诉我,“矩阵乘法”是什么?

它就是成千上万个简单的、重复的、彼此独立的“乘法-加法”运算42。

它……它不就是……**“翻肉饼”**吗?!

“啊哈!”时刻:

- 在80年代和90年代,辛顿和杨立昆(可怜的人)正试图让那个“米其林大厨”(CPU)一个接一个地翻一百万个肉饼。训练一个模型需要几周甚至几个月的时间43。

- 大约在2009-2012年,AI研究人员(在英伟达Nvidia的帮助下,他们开发了CUDA这个“厨房管理软件”42)突然意识到:我们可以用那个“麦当劳厨房”(GPU)啊!44。

- 结果: 训练时间从几周缩短到了几小时。沉睡了30年的算法(反向传播)1,终于找到了它天选的硬件(GPU)。水坝决堤了。

15.7 宇宙大爆炸:2012,一个游戏竞赛如何改变了世界

这场“幸福的联姻”需要一个向全世界展示肌肉的舞台。

这个舞台,就是“ImageNet 大型视觉识别挑战赛”(ILSVRC)45。

- 场景设置: 在2012年之前,ImageNet是“符号AI”(规则派)的奥林匹克。来自全球顶尖大学的团队,带着他们手工编写了十年的、极其复杂的“特征提取器”(IF has_whiskers...的21世纪高级版)来参赛,争夺那零点几个百分点的识别率提升。

- 闯入者:

- 2012年,“异教徒”来了。

- 一个名不见经传的团队,名叫“SuperVision”。成员:Geoffrey Hinton(那位偏执了几十年的教父)和他的两名学生,Alex Krizhevsky 和 Ilya Sutskever(对,就是后来OpenAI的那个Ilya)20。

- 他们的“武器”:

- 结果:这不是胜利,这是一场“屠杀”

- 它不仅赢了。它摧毁了第二名。它比第二名整整好出了40%多。在AI领域,这不叫进步,这叫“外星人入侵”20。

- 余波:

15.8 结论:新世界,新角色

所以,旅行者,你现在明白了。我们并没有创造出一个“智能”。我们创造了一个统计学奇迹。

这个“新脑”1不是一个逻辑学家(像你)。它是一个蛮力模式匹配器(a brute-force pattern-matcher)36。

它不是通过“理解”来工作的。它是通过“看过一亿张猫片”来工作的。

它不是斯波克。它是一个拥有6000万个旋钮(权重)的巨型收音机,我们(通过反向传播)花了三年时间(训练)把它调优到只接收“猫”这个频道。

欢迎回来。你的世界变了。你不再是那个编写规则的“建筑师”了。那个方法失败了5。

在这个新世界里,你的角色更像是... 一个极其古怪的马戏团驯兽师。

你不再编写 IF-THEN。你现在的工作是:

- 收集食物 (Data): 找到数百万张图片(数据)。

- 设计鞭子 (Loss Function): 定义一个数学函数,用来衡量“猜错”有多“疼”(损失函数)。

- 开始训练 (Training): 站在一边,看着那个庞大、愚蠢的官僚机构(神经网络)在那个嘈杂、炎热的麦当劳厨房(GPU)里,一遍又一遍地运行“甩锅大会”(反向传播)。

- 调整(Tuning): 祈祷,并调整(Tuning)几百个旋钮(超参数),直到这个“野兽”学会(在统计上)不再把“7”认成“3”。

这不优雅。这不合逻辑。它甚至有点... 蠢。

但它管用。

欢迎来到“代码山”,旅行者。带上你的鞭子。

引用的著作

-

What is a neural network? | Types of neural networks - Cloudflare, 访问时间为 十月 27, 2025, https://www.cloudflare.com/learning/ai/what-is-neural-network/ ↩︎ ↩︎

-

Looking back, looking ahead: Symbolic versus connectionist AI, 访问时间为 十月 27, 2025, https://ojs.aaai.org/aimagazine/index.php/aimagazine/article/view/15111/18883 ↩︎ ↩︎

-

Expert system - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/Expert_system ↩︎ ↩︎

-

Rule-based AI vs machine learning: Key differences - WeAreBrain, 访问时间为 十月 27, 2025, https://wearebrain.com/blog/rule-based-ai-vs-machine-learning-whats-the-difference/ ↩︎ ↩︎

-

Expert Systems: Dendral & Mycin | PDF - Scribd, 访问时间为 十月 27, 2025, https://www.scribd.com/doc/116906821/Expert-Systems-Dendral-Mycin ↩︎ ↩︎ ↩︎

-

Computers, Artificial Intelligence, and Expert Systems in Biomedical Research | Joshua Lederberg - Profiles in Science, 访问时间为 十月 27, 2025, https://profiles.nlm.nih.gov/spotlight/bb/feature/ai ↩︎

-

An Overview of the Rise and Fall of Expert Systems | by Shaq Arif ..., 访问时间为 十月 27, 2025, https://medium.com/version-1/an-overview-of-the-rise-and-fall-of-expert-systems-14e26005e70e ↩︎ ↩︎ ↩︎ ↩︎

-

Lighthill report - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/Lighthill_report ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

-

AI winter - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/AI_winter ↩︎ ↩︎ ↩︎

-

A Chilly History: How a 1973 Report Caused the Original AI Winter, 访问时间为 十月 27, 2025, https://www.aiinnovationsunleashed.com/a-chilly-history-how-a-1973-report-caused-the-original-ai-winter/ ↩︎

-

Norvig vs. Chomsky and the Future of AI - Great debate over at LinkedIn : r/linguistics, 访问时间为 十月 27, 2025, https://www.reddit.com/r/linguistics/comments/130ar5/norvig_vs_chomsky_and_the_future_of_ai_great/ ↩︎

-

On Chomsky and the Two Cultures of Statistical Learning, 访问时间为 十月 27, 2025, https://norvig.com/chomsky.html ↩︎ ↩︎ ↩︎ ↩︎

-

Interview: Yoshua Bengio, Yann LeCun, Geoffrey Hinton, 访问时间为 十月 27, 2025, https://blog.re-work.co/interview-yoshua-bengio-yann-lecun-geoffrey-hinton/ ↩︎ ↩︎

-

Geoffrey Hinton - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/Geoffrey_Hinton ↩︎

-

Yann LeCun - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/Yann_LeCun ↩︎

-

Artificial Intelligence: Past, Present and Future - Scholar Commons, 访问时间为 十月 27, 2025, https://scholarcommons.sc.edu/cgi/viewcontent.cgi?article=1264&context=jscas ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

-

Geoffrey Hinton: The 100 Most Influential People in AI 2023 - Time Magazine, 访问时间为 十月 27, 2025, https://time.com/collection/time100-ai/6309026/geoffrey-hinton/ ↩︎

-

Long-time CIFAR Fellow Geoffrey Hinton awarded 2024 Nobel Prize in Physics, 访问时间为 十月 27, 2025, https://cifar.ca/cifarnews/2024/10/08/long-time-cifar-fellow-geoffrey-hinton-awarded-2024-nobel-prize-in-physics/ ↩︎

-

Between the Booms: AI in Winter – Communications of the ACM, 访问时间为 十月 27, 2025, https://cacm.acm.org/opinion/between-the-booms-ai-in-winter/ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

-

The AI Brain: A Simple Explanation of How Deep Learning Works | by Baran Özdemir, 访问时间为 十月 27, 2025, https://medium.com/@Baran-Ozdemir/the-ai-brain-a-simple-explanation-of-how-deep-learning-works-d1fe045bbd3c ↩︎

-

Neural network (machine learning) - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/Neural_network_(machine_learning) ↩︎ ↩︎

-

What Is a Neural Network? | IBM, 访问时间为 十月 27, 2025, https://www.ibm.com/think/topics/neural-networks ↩︎ ↩︎ ↩︎

-

What do the neural network's weights represent conceptually? - AI Stack Exchange, 访问时间为 十月 27, 2025, https://ai.stackexchange.com/questions/6776/what-do-the-neural-networks-weights-represent-conceptually ↩︎

-

Introduction to neural networks — weights, biases and activation | by Andrea D'Agostino, 访问时间为 十月 27, 2025, https://medium.com/@theDrewDag/introduction-to-neural-networks-weights-biases-and-activation-270ebf2545aa ↩︎ ↩︎

-

Activation Functions in Neural Networks: 15 examples - Encord, 访问时间为 十月 27, 2025, https://encord.com/blog/activation-functions-neural-networks/ ↩︎

-

Yes you should understand backprop | by Andrej Karpathy | Medium, 访问时间为 十月 27, 2025, https://karpathy.medium.com/yes-you-should-understand-backprop-e2f06eab496b ↩︎

-

ImageNet Classification with Deep Convolutional Neural Networks, 访问时间为 十月 27, 2025, https://proceedings.neurips.cc/paper/4824-imagenet-classification-with-deep-convolutional-neural-networks.pdf ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎ ↩︎

-

A Neural Network Invents Hilarious Pickup Lines That Definitely Wouldn't Work - Nerdist, 访问时间为 十月 27, 2025, https://archive.nerdist.com/a-neural-network-invents-hilarious-pickup-lines-that-definitely-wouldnt-work/ ↩︎

-

Backpropagation — When your AI learns to blame everyone else! - Hugging Face, 访问时间为 十月 27, 2025, https://huggingface.co/blog/RDTvlokip/when-your-ai-learns-to-blame-everyone-else ↩︎

-

How the backpropagation algorithm works - Neural networks and ..., 访问时间为 十月 27, 2025, http://neuralnetworksanddeeplearning.com/chap2.html ↩︎ ↩︎ ↩︎

-

Explain like I'm five: Backpropagation, 访问时间为 十月 27, 2025, https://towardsdatascience.com/explain-like-im-five-backpropagation-38d1cec94ee5/#:~:text=Simply%20put%2C%20backpropagation%20is%20a,prediction%20and%20given%20target%20values. ↩︎

-

What is backpropagation really doing? - 3Blue1Brown, 访问时间为 十月 27, 2025, https://www.3blue1brown.com/lessons/backpropagation ↩︎ ↩︎ ↩︎ ↩︎

-

Explain like I'm five: Backpropagation | Towards Data Science, 访问时间为 十月 27, 2025, https://towardsdatascience.com/explain-like-im-five-backpropagation-38d1cec94ee5/ ↩︎

-

Backpropagation, intuitively | Deep Learning Chapter 3 - YouTube, 访问时间为 十月 27, 2025, https://www.youtube.com/watch?v=Ilg3gGewQ5U&vl=en ↩︎

-

Understanding Backpropagation | Towards Data Science, 访问时间为 十月 27, 2025, https://towardsdatascience.com/understanding-backpropagation-abcc509ca9d0/ ↩︎ ↩︎

-

CPU vs. GPU for Machine Learning - IBM, 访问时间为 十月 27, 2025, https://www.ibm.com/think/topics/cpu-vs-gpu-machine-learning ↩︎ ↩︎

-

CPU vs. GPU: What's the Difference? - Intel, 访问时间为 十月 27, 2025, https://www.intel.com/content/www/us/en/products/docs/processors/cpu-vs-gpu.html ↩︎

-

Can someone smarter than me explain like I'm five why GPUs are used for things like Artificial Intelligence and cryptocurrency mining and not processors? : r/computers - Reddit, 访问时间为 十月 27, 2025, https://www.reddit.com/r/computers/comments/1ilqotn/can_someone_smarter_than_me_explain_like_im_five/ ↩︎

-

AI is Powered by GPUs. It's Time to Understand What They Are. | by ..., 访问时间为 十月 27, 2025, https://medium.com/@technormal/ai-is-powered-by-gpus-its-time-to-understand-what-they-are-79787495141d ↩︎

-

High Performance Matrix Multiplication - arXiv, 访问时间为 十月 27, 2025, https://arxiv.org/html/2509.04594v1 ↩︎

-

Why can GPU do matrix multiplication faster than CPU? - Stack Overflow, 访问时间为 十月 27, 2025, https://stackoverflow.com/questions/51344018/why-can-gpu-do-matrix-multiplication-faster-than-cpu ↩︎ ↩︎

-

[D] ML old-timers, when did deep learning really take off for you? - Reddit, 访问时间为 十月 27, 2025, https://www.reddit.com/r/MachineLearning/comments/hoo6m8/d_ml_oldtimers_when_did_deep_learning_really_take/ ↩︎

-

A brief history of AI: how to prevent another winter (a critical review) - ar5iv - arXiv, 访问时间为 十月 27, 2025, https://ar5iv.labs.arxiv.org/html/2109.01517 ↩︎

-

AlexNet - Wikipedia, 访问时间为 十月 27, 2025, https://en.wikipedia.org/wiki/AlexNet ↩︎

-

AlexNet and ImageNet: The Birth of Deep Learning - Pinecone, 访问时间为 十月 27, 2025, https://www.pinecone.io/learn/series/image-search/imagenet/ ↩︎