本期封面由 来自 theinformation

创刊目的:学习 AI 领域新知过程,记录文档与信源,分享好内容。

更新什么: AI |设计 热点资讯、设计资源&我能看懂的基础知识

周刊特质:不全,不新,也许与你有关

🍃 试图在冗杂信息里由下至上理序,

💥 爆炸的永远是信息,而不是知识。

欢迎订阅,如果无法订阅,请跳转到浏览器:屋下 AI 设计周刊

周刊拖延好久没发,一方面最近工作生活变动,另一方面也因内容太过难以理解,尤其这篇通过知识蒸馏实现的隐式思维链推理,太难理解了。orz...

直到 OpenAI o1 发布预览版,才有些理解,下下篇我们一起了解。

往下看,我们一起学习。

🤖 上上周精选

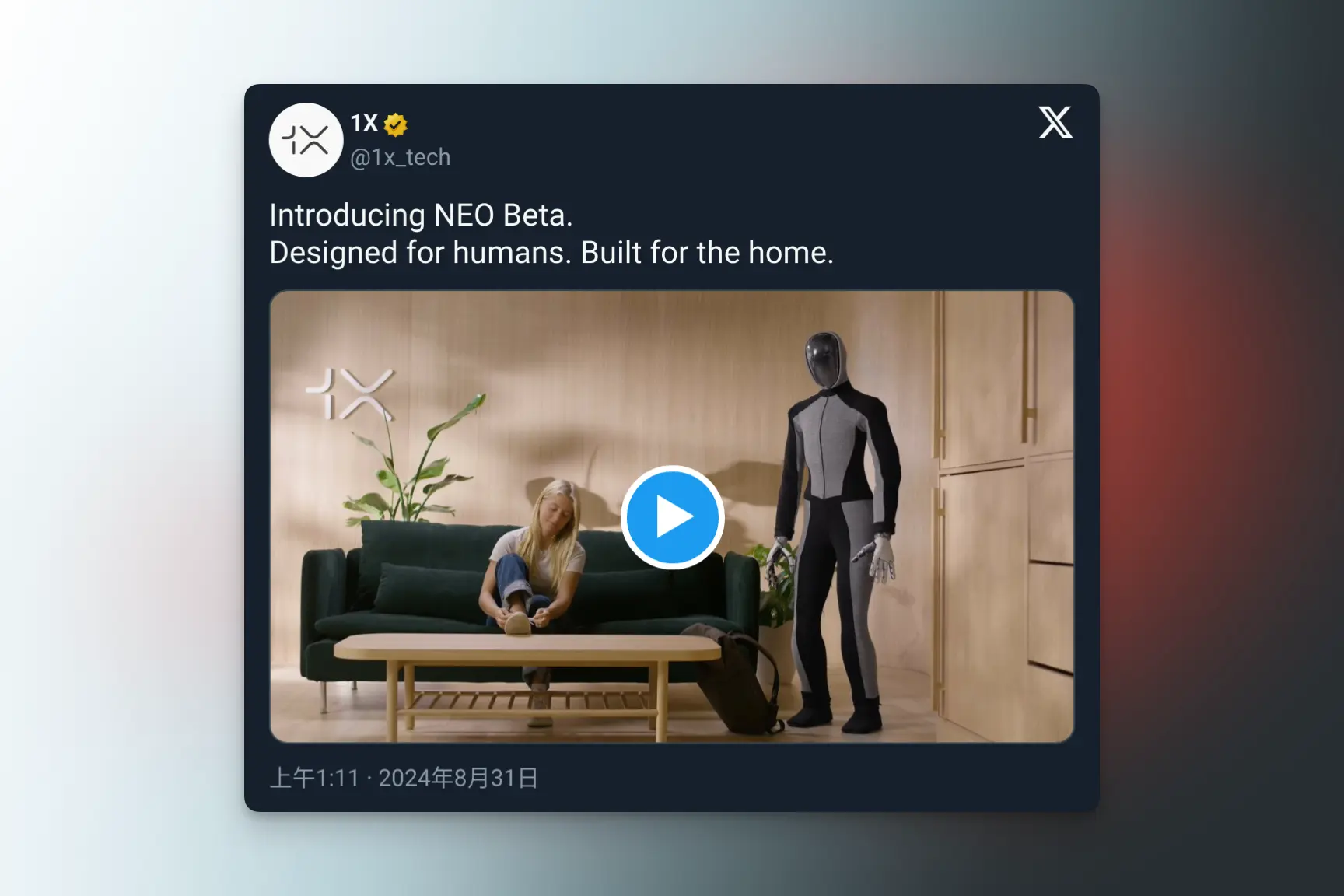

OpenAI加持,1X消费级人形机器人亮相

OpenAI 注资的机器人创业公司 1X 宣布正式推出一款专为家庭使用而设计的双足人形机器人原型 —— NEO Beta。

看起来像是个套皮真人 🤣

NEO 专为家务服务设计,主打安全与超静音,运行时间2-4小时。

NEO 的身体采用类似人类肌肉组织的结构设计,因此显得更温和。又因为是仿人类设计,可以更好地融入人类世界,无需做太多改变。

「草莓」即将上线,OpenAI新旗舰大模型曝光,代号Orion(猎户座)

本月初,OpenAI 创始人CEO 山姆・奥特曼在 X 上发布了一张草莓照片引发讨论,许多人都猜测是 OpenAI 预计在今秋要推出的代号「草莓」的新人工智能。

据悉,「草莓」可以解决它从未见过的数学问题,同时据 The Information 报道,OpenAI 正在研发新型 LLM,代号「Orion(猎户座)」,旨在改进现有LLM 模型——GPT-4

「草莓」的推出,是为了训练「Orion」而生,通过 OpenAI 内部称为蒸馏(distillation)的过程来简化和缩小「草莓」。

利用生成的数据来训练「Orion」,目前只能等待更多公开信息。(已证实是 OpenAI o1)

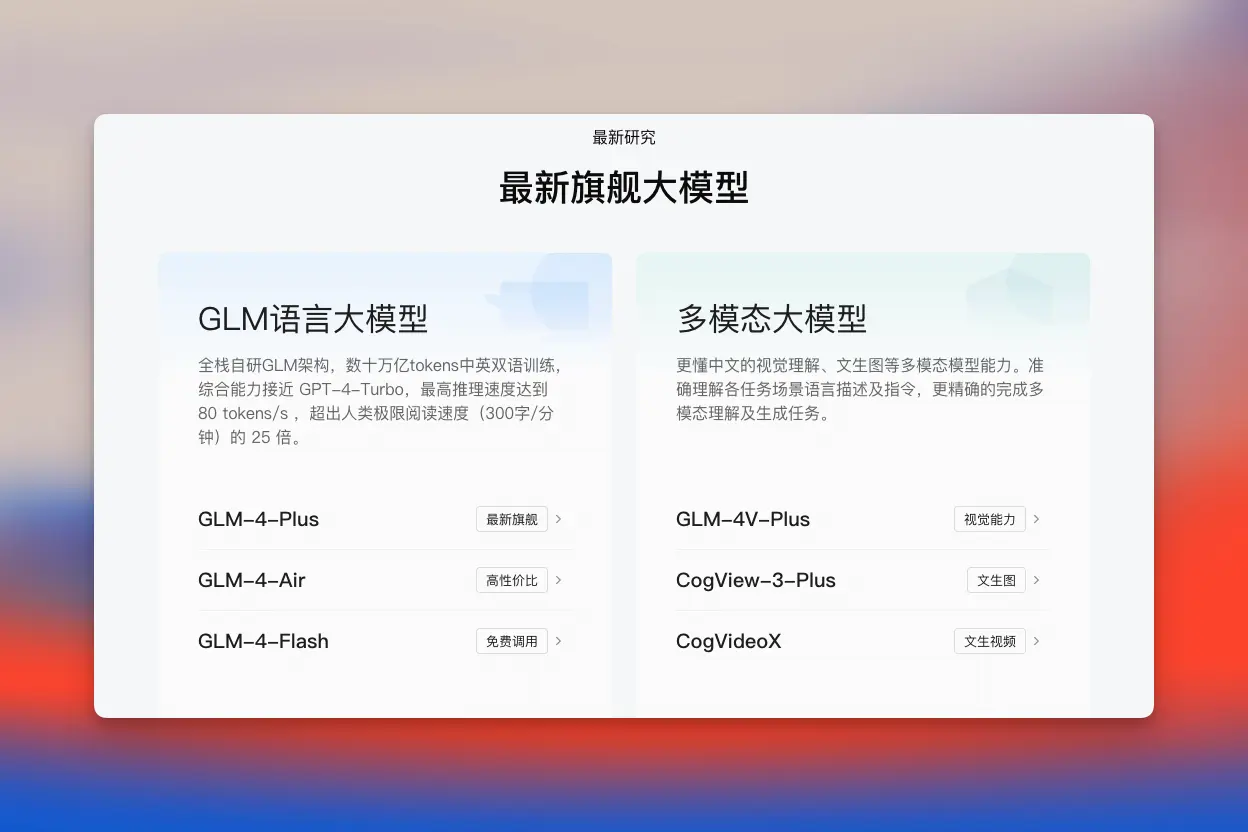

智谱公开GLM-4-Flash,免费

智谱发布最新基座大模型 GLM-4-Flash 免费开放给所有人。可以通过 bigmodel 登录调用 GLM-4-Flash 进行构建专属模型与应用。

这也是智谱开放平台首个完全免费的大模型 API 。

Claude 系统提示词现已公布

在 Anthropic 的最新文档的更新日志里增加了一个「系统提示词」板块,里面详细记录了 Claude 目前3种模型的提示词与更新记录。

最近都在使用 Claude,所以扒来学习学习。

Claude 3.5 Sonnet :

- 身份确认:明确了 Claude 的身份和知识时间范围。

- 限制指令:通过用「不使用道歉语言」来确保输出内容准确性。

- 逐步解答:处理复杂问题,如数学题时用逐步解答的方式提供答案。

- 面盲性:通过限制「不识别所有图像人脸身份」的限制人脸识别。

- 幻觉提醒:在解答互联网上不常见的问题时,在结尾提示用户避免「幻觉」

Opus 和 Haiku 的完整提示词也在文档里,感兴趣可以自己试试。

🍃 有用设计

假装旅行|Vector Journey LoRA

推荐 Muertu 训练的 Flux 模型 Vector Journey 非常有趣,生成卡通人物+真实背景结合,很适合在小红书朋友圈发布,截止发文模型已不公开,静待后续。

鸭力巨大压缩工具

完全免费的在线图片/视频压缩工具,无需任何下载,即开即用。

支持的图片格式有PNG、JPG、GIF,

支持的视频格式有MP4、avi、mov等

提供3种压缩模式,能够满足大多数用户的日常需求:

- 有损压缩-会稍微降低图片/视频的清晰度,但会显著压缩文件,一般在50%左右;

- 无损压缩-肉眼无法察觉到图片/视频清晰度的改变,但节约空间的效果并不明显;

- 高级模式-支持用户自定义压缩率,获取不同压缩质量的图片/视频;

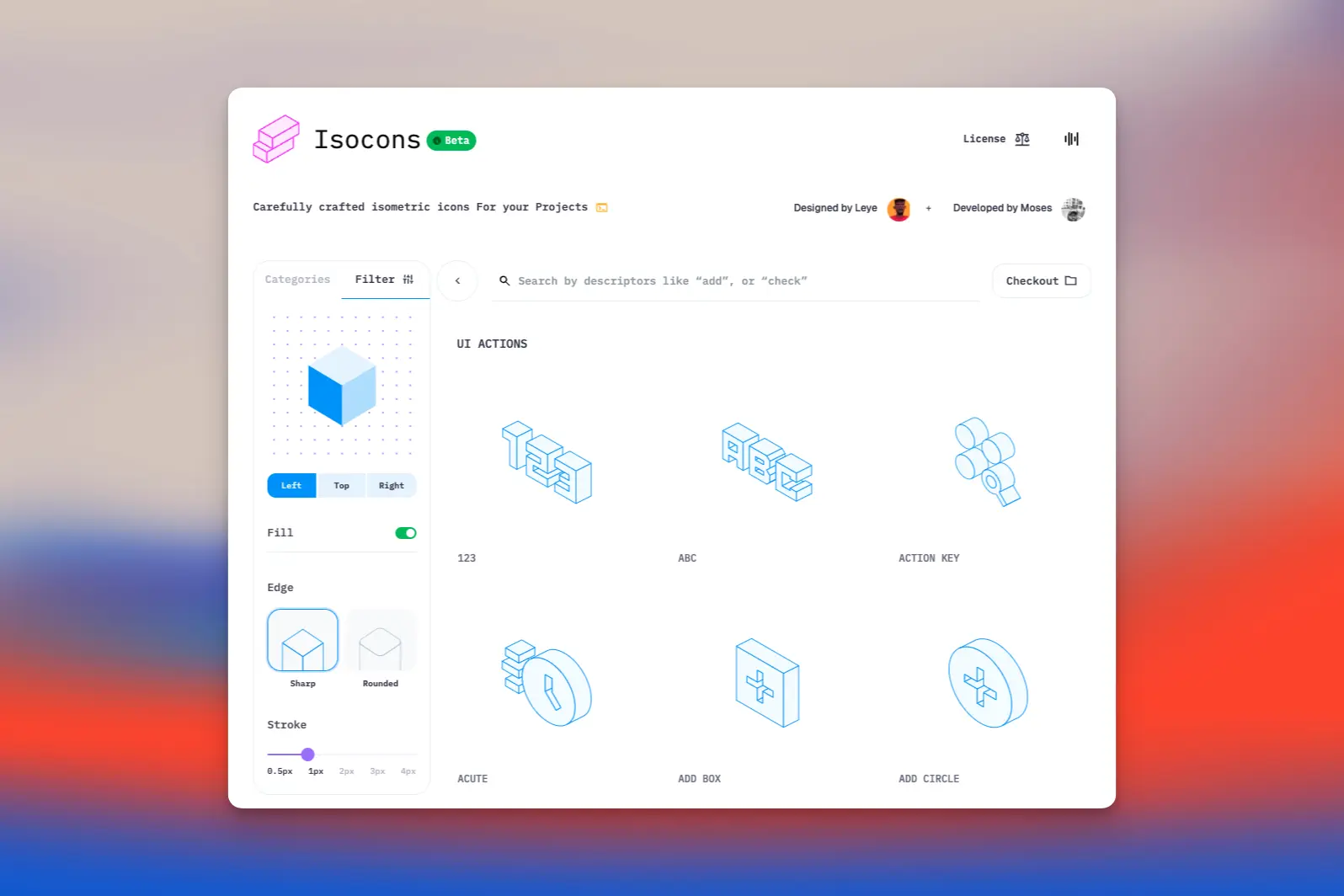

等距 icon网站-Isocons

特别赏心悦目的等距 icon合集。

网站做得太优秀了,非常推荐大家去观摩把玩,有很多小细节。可以选择多种角度、样式、尺寸与PNG、SVG输出格式。

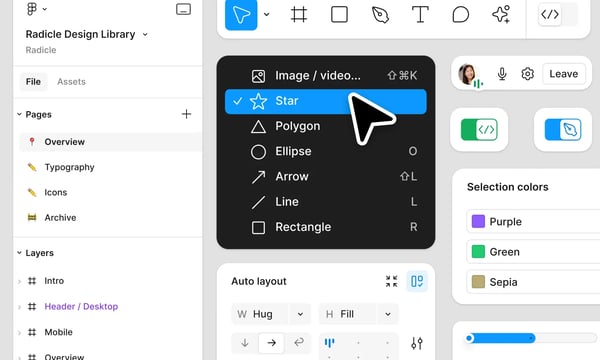

透视网格工具:Perspective Grid Tool

可以在 Figma 直接拖动与排版来创造透视图,内置两点透视。

组件特点:

- 使用矩形绘制透视形状。

- 自由调整消失点和水平线。

- 自动调整网格。

- 在选择模式下,可以转换文本、矢量、椭圆、多边形等以在透视图中显示。

🧀 上周,我都看了什么?

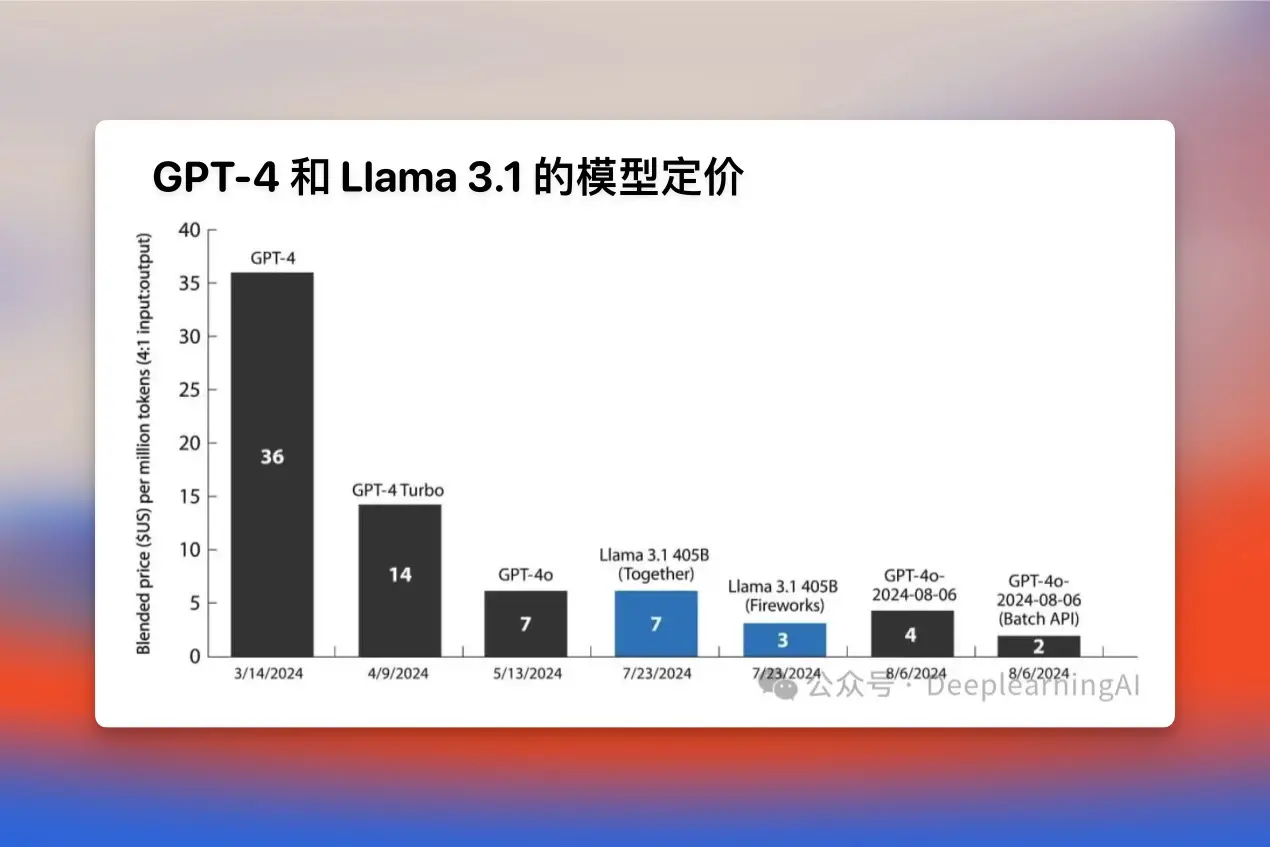

吴恩达来信:LLM token价格的下降及其对AI公司的意义

随着 OpenAI 对 token 价格进行下调后,各大模型厂商纷纷下调价格,甚至有些厂商开放免费 API,同时硬件厂商也在进一步推动价格价格下调。

价格调整的一个重要因素是如 Llama 3.1 这类开源模型的发布,以及各级厂商需要新的动力来推动新产品研发与创收。

价格下调的一个最大好处是决策成本降低,不需要更多地考虑价格成本,很多时候(个人或企业)会发现 LLM 的使用成本是比预计低的。

当价格不需要过度优化,就应该更专注于构建程序。其次,那些曾经因为 LLM 运行成本过高的项目,也能够在未来价格进一步降低的同时完成部署与市场推广。

通过知识蒸馏实现的隐式思维链推理 [译]

何为「知识蒸馏」

之前看各种 LLM 发布,总能看到知识蒸馏的概念,一直以为是从大模型中「提取」部分算力到新模型里,就是蒸馏了🤣。

而实际上,「知识蒸馏」的概念大致分3个步骤:

1. 读心

用性能较好的大模型作为「教师模型」去指导一个新的「学生模型」,将知识传递给「学生模型」,通过这种方式,即使是小规模的「学生模型」也能学习到「教师模型」的知识。

2. 预测隐藏

再建立一个模型去学习大型教师模型生成包含思维链的完整推理过程。从而让「学生模型」掌握在不显示思维过程的情况下也能准确回答。这就是「知识蒸馏」的过程。

大模型在推理过程中会有很多思考过程状态,如果完全展示,不仅过程冗长,而且效率低下。因此在生成过程大模型将思维推理过程进行隐藏,从而加快生成结果速度。

3. 结合

在前两步训练后,「学生模型」不仅能快速给出结果,还能保持较高的性能。

「知识蒸馏」的意义:

很有趣,用小模型去学习掌握大模型的能力与性能,是典型的「以小博大」的结果。

小模型对移动设备的意义是非常重要的,如果能出现 GPT-4级别的「超级小模型」,那得多有趣。

感谢你看到这里,如果内容对你有帮助的话,欢迎你订阅我的周刊。

基于微信对外链不完善支持,在微信可能看不到邮箱订阅。

可以点击右上角跳转到浏览器订阅/

留下邮箱,我会定期同步到你的邮箱上。

愿你一周开个好头 🍃